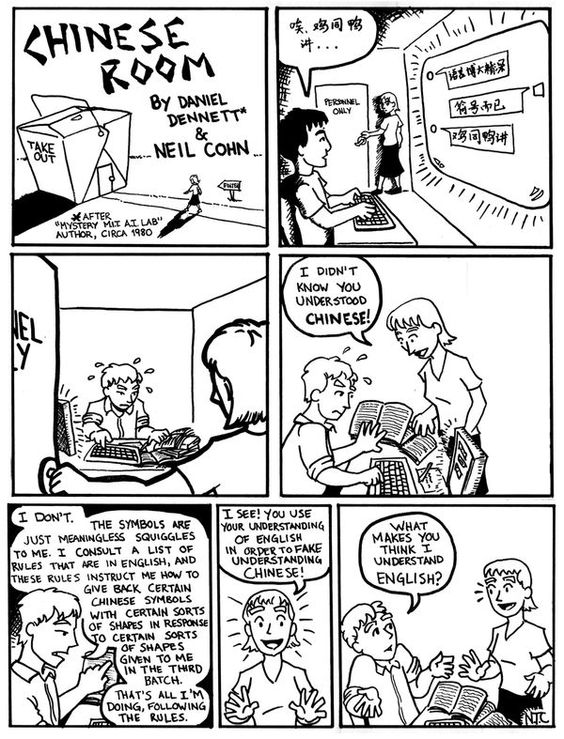

Es tan conocidísimo el argumento de Searle conocido como la habitación china (también la caja o la pieza china) que casi no merece la pena soltar el rollo de volverlo a explicar, pero, por si acaso hay algún despistado, lo volveremos hacer. Searle hace una comparación entre un supuesto computador que supera el test de Turing y una curiosa situación: imaginemos a un hombre que se encuentra en una habitación en la que hay una ventana. A través de esa ventana recibe frases escritas en chino. Él no tiene idea de chino, pero dispone de un libro con una serie de instrucciones escritas en inglés (su lengua materna) en las que se indica qué frases hay que decir ante cualquier frase en chino que uno reciba, de tal modo que la persona que se encuentre al otro lado de la ventana no sabría decir si está hablando con una persona que habla chino o no. Lo que Searle pretende argumentar es que el operario de la habitación no comprende chino, solo sabe un tipo de sintaxis, juntar símbolos con otros de una determinada manera y, sin embargo, parece que lo comprende, por lo que el test de Turing no es válido para determinar si un ordenador piensa o no. Para Searle, pensar tiene que ver con comprender, es decir, con conocer una cierta semántica. Las computadoras solo saben de sintaxis, de unir o separar unos símbolos con otros siguiendo unas reglas marcadas, nada más, y eso no es realmente entender nada.

Durante mucho tiempo este argumento me pareció inapelable y lo utilizaba con asiduidad para criticar las pretenciosas afirmaciones de los entusiastas de la Inteligencia Artificial. Sin embargo, hace poco descubrí el error que encierra (y me sorprendí de cómo no lo había descubierto antes. Quizá porque estaba hechizado con la brillante y sencilla prosa de Searle) y también descubrí que, para desgracia de mi descubrimiento, ya se habían escrito toneladas de artículos en esa línea. Y es que el argumento de Searle ya tiene unos cuantos añitos. No obstante, como después explicaré, el error es solo en una de las tesis que Searle deriva del argumento, siendo lo demás correcto, porque sigo pensando que, en términos generales, el argumento de Searle es correcto.

El error está en que no se pueden separar taxativamente sintaxis y semántica, es más, no se pueden separar ni siquiera un milímetro, ya que la una sin la otra no tienen ningún sentido. Supongamos que estamos usando la habitación china y cualquiera de nosotros es su operario. Entonces recibimos este mensaje:

早安

Esto es «Buenos días» en chino tradicional. ¿Qué instrucción pone en nuestro libro que respondamos y por qué? Podría haber muchas respuestas posibles pero una de ellas de puro sentido común sería que devolviéramos el saludo:

早安

¿Por qué devolver el saludo es una buena respuesta que nos llevaría por buen camino para superar el test de Turing? Para devolver el saludo necesitamos una información previa que no puede reducirse a mera sintaxis: necesitamos saber que cuando alguien te saluda es habitual devolver el saludo, es decir, necesitamos comprender el contexto, las circunstancias en donde se da esa frase en chino, y eso es un elemento metalingüístico o metasintáctico que no obedece a una sintaxis determinada.

Por ejemplo, cuando el saludo no se da al principio de la conversación sino al final o en medio, esto suele indicar que la conversación se termina. Quizá nuestro interlocutor se ha sentido ofendido por algo que dijimos y quiere finalizar la conversación de un modo educado pero cortante. O, quizá, nuestro interlocutor es un desconocido que solo nos quiere saludar por educación pero no quiere comenzar conversación alguna ya que no nos conoce. ¿Cómo saber esto? Sólo comprendiendo el contexto, huelga decir, sabiendo semántica. Entonces, para pasar el test de Turing, necesariamente, tenemos que enseñar semántica a nuestra habitación china. Las reglas que el operador de la habitación maneja deben incorporar semántica para que puedan superar el test de Turing

Para desgracia del argumento de Searle, podríamos enseñar a un computador semántica. No habría ningún problema (a priori) en enseñar a la máquina a saber qué puede significar una proposición dado un contexto dado puesto que podríamos traducir la semántica a sintaxis. Si la semántica puede reducirse a reglas no hay impedimento. En el ejemplo podríamos introducir en el programa las diferentes situaciones en las que puede darse un saludo y establecer nuevas reglas dado el contexto anterior o futuro de la conversación. El problema (ahora sí, a posteriori) es la enorme riqueza de los contextos en donde puede darse una conversación. Llegamos al frame problem, del que pronto hablaremos en otra entrada.

Sin embargo, para lo que el argumento de la habitación china sí que tiene clara validez es en dos sentidos: uno es para hablar de la consciencia o de los qualia. Podríamos tener una máquina que comprendiera muy bien el contexto de las afirmaciones de una conversación y que pudiera pasar el test de Turing, pero eso no indicaría nada sobre su consciencia. La máquina seguiría siendo tan inconsciente de sus acciones como lo es mi tostador sobre el estado de las tostadas. Y en otro acerca de lo que hacen las computadoras actuales con respecto a lo que pasa en mi cerebro cuando pienso: no es lo mismo. Un programa de ajedrez no hace lo mismo que yo cuando decide mover una pieza en el tablero y una calculadora no hace lo mismo que yo cuando realiza una multiplicación. Y con respecto al lenguaje, programas clásicos como la Eliza de Weizenbaum o la Siri de los Iphone no hacen lo mismo que nosotros cuando se comunican con nosotros. Las analogías que puedan encontrarse no son, ni de lejos, suficientes para decir que las máquinas piensan si por pensar nos referimos a cómo lo hacemos los seres humanos.

En palabras de de Jerry Kaplan:

Searle argumenta que, en realidad, éstas deben ser cosas distintas, pero simplemente no entendemos aún lo que está haciendo el cerebro. Es importante entender qué no está diciendo. No está afirmando ninguna propiedad mágica de la mente humana que transcienda el ámbito de la ciencia: sus pies están firmemente plantados en el suelo, con un creencia en el mundo físico como (en su mayor parte) determinista, sujeto a medición y a explicación racional. Sólo está diciendo que en nuestros cerebros ocurre algo que aún no entendemos y que, cuando lo consigamos (lo cual acepta como probable), se aclarará el camino para una explicación satisfactoria de lo que él cree que son fenómenos exclusivamente humanos; no sólo «pensar», sino también la consciencia, la sensación de experimentar cosas (lo que los filósofos llaman «qualia»), la percepción, etc. Tampoco está afirmando que un programa informático nunca pueda realizar ninguna tarea concreta; ya sea pintar bellos cuadros, descubrir leyes de la naturaleza o consolarnos por la muerte de un ser querido. Pero él cree que el programa está simulando el pensamiento, no duplicando el proceso que tiene lugar en las mentes humanas cuando se implican en estas actividades. Para Searle, un piano informático no está haciendo lo mismo que un maestro de la música, cuando ejecutan un concierto de Rachmaninoff, aunque suene igual. Resumiendo, Searle dice que, en lo relativo a los ordenadores, al menos tal como existen en la actualidad, nadie tiene toda la razón.

Y es que, ya lo he dicho cientos de veces, el problema de la Inteligencia Artificial no es fabricar agentes inteligentes (lo cual ya lo hace con mucho éxito en algunos casos), sino agentes conscientes o sintientes. La AI ya ha fabricado inteligencia, lo que hace falta es que fabrique mentes.

P. D. : Por si aún no lo habéis leído, hace poco me han publicado un artículo mucho más extenso sobre estos temas en Xataka.