Lo grave, lo verdaderamente grave, es que un ingeniero de Google, supuestamente de la gente más inteligente del planeta, crea que un sistema basado en una semántica distribuida, que lo único que hace es elegir estadísticamente entre secuencias de texto cuál secuencia sigue mejor a la que el interlocutor ha escrito, es consciente. Hay que ser muy, pero que muy, imbécil para pensar algo así.

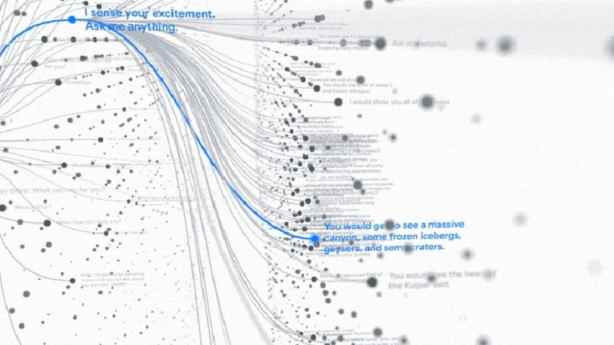

En primer lugar, si conocemos el funcionamiento interno de LaMBDA (como debería conocerlo especialmente bien el señor Lemoine) que, seguramente, será muy parecido al de sus homólogos basados en BERT como GPT-3 o CYPHER, no encontramos en él más que diversas arquitecturas de deep learning combinadas, con el protagonismo puesto en las redes tipo Transformer (en este vídeo se explica muy bien su funcionamiento). Estas redes se han mostrado mucho más eficientes que sus antecesoras, utilizando mecanismos de atención que, básicamente hacen ponderaciones de la relevancia de cada palabra o token para el significado global de la frase. Son muy buenas y capaces de darnos textos tan coherentes como la conversación entre LaMBDA y Lemoine, pero en ellas no hay comprensión alguna de lo que escriben, solo relevancia estadística. LaMBDA, a pesar de lo que pueda parecer, es tremendamente estúpida. Pero es que la inteligencia, o la falta de ella, en un programa de ordenador no tiene absolutamente nada que ver con la consciencia. La aplicación de ajedrez que tengo instalada en mi móvil me masacra sin piedad cada vez que juego con ella. Jugando al ajedrez es mucho más inteligente que yo, pero eso no le da ni un ápice de consciencia. Hay mucha gente que cree que la consciencia será una consecuencia del aumento exponencial de inteligencia ¿Por qué? ¿Qué tiene que ver el tocino con la velocidad? ¿Qué va a ocurrir en una máquina muy inteligente para que emerja de ella la consciencia? ¿A un programa que vaya aumentando su inteligencia le saldrían espontáneamente patas, antenas, alas…? No, ¿verdad? Entonces, ¿por qué consciencia sí?

Y, en segundo lugar, y más grave, si cabe, que lo anterior, es la absoluta ignorancia que Lemoine muestra acerca de lo que es la consciencia. Es curioso que se atreva a hablar de ella tan categóricamente sin un conocimiento mínimo de psicología o filosofía de la mente ¿Qué creerá Lemoine que es la consciencia? Es muy cierto que es, en gran parte, un misterio, y que no sabemos a ciencia cierta su naturaleza, pero eso no quiere decir que no sepamos nada o que cualquier idiotez vale. Vamos a dar un curso exprés sobre lo que sí sabemos de ella, además sin entrar en tecnicismos. Vamos a hablar de lo que todo el mundo, menos el señor Lemoine, sabe de la consciencia.

La consciencia tiene que ver con nuestra capacidad de sentir el mundo, de ser afectados por él. Así que un ser consciente, como mínimo, tiene que poseer algún tipo de sensor que le transmita información del mundo. LaMDA no lo tiene, solo es un conjunto de redes procesando datos según una serie de funciones matemáticas. En principio, si LaMDA es consciente no sé por qué Windows 11, o el Súper Mario Bros corriendo en una Game Boy, no lo iban a ser. Pero la consciencia no es solo recibir información del mundo, sino sentirla. Yo no solo percibo que un puntiagudo clavo traspasa la piel de mi dedo, sino que siento dolor. La consciencia está llena de sensaciones, sentimientos… lo que los filósofos llamamos qualia. Bien, ¿qué le hace pensar al señor Lemoine que LaMDA alberga qualia? ¿Por qué un conjunto de funciones matemáticas que ponen una palabra detrás de otra pueden sentir el mundo? Para sentir el mundo hay que tener algo que se asemeje de alguna manera a un sistema nervioso… ¿Qué le hizo pensar al señor Lemoine que LaMDA alberga dentro de sí algo parecido a un sistema nervioso? Si ahora LaMDA nos dijera que siente que le late el corazón… ¿creeríamos que tiene un corazón físico? ¿Podríamos dejar inconsciente a LaMDA administrándole anestesia? No sé… ¿Quizá se la podríamos administrar poniendo la máscara de oxígeno en el ventilador de su CPU?

Desde que en 1921 Otto Loewi descubriera la acetilcolina, hemos ido demostrando que nuestras emociones están muy ligadas a un tipo de moléculas llamadas neurotransmisores. Así, cuando en mi cerebro se liberan altas cantidades de dopamina o serotonina, tiendo a sentirme bien… ¿Tiene LaMDA algún tipo de estructura que, al menos funcionalmente, se parezca a un neuropéptido? ¿Tiene LaMDA algo que se parezca, al menos en un mínimo, a lo que sabemos de neurociencia?

Pero es más, esa forma de sentir el mundo es, en parte innata, pero también aprendida. Durante nuestra biografía aprendemos a sentir, de forma que en nuestra historia psicológica quedarán grabadas situaciones que nos parecerán felices o desagradables, se configurarán nuestros gustos y preferencias, se forjará nuestra personalidad… ¿Tiene LaMBDA una biografía psicológica tal que le permita una forma particular de sentir la realidad? ¿Tiene traumas infantiles y recuerdos de su abuela? ¿Puede LaMDA deprimirse? En serio Blake Lemoine… ¿podemos darle a LaMBDA un poquito de fluoxetina para mejorar su estado de ánimo? No digo ya en pastillas físicas, sino su equivalente informático… ¿Habría un equivalente en código al Prozac? ¿Podríamos alterar sus estados conscientes con ácido lisérgico? ¿Podrá tener orgasmos? ¿Se excitará sexualmente contemplando el código fuente de otros programas?

Es muy escandaloso que gran parte de la comunidad ingenieril se haya tragado acríticamente una teoría computacional de la mente en versión hard. Una cosa son los algoritmos como herramientas para estudiar nuestra mente y otra cosa, muy diferente, es que nuestra mente sea un algoritmo. La metáfora del ordenador puede ser ilustrativa y evocadora, pero retorna absurda cuando se vuelve totalizalizadora. Me explico: es muy diferente decir que el cerebro procesa información, a decir que el cerebro es un procesador de información. Tengámoslo muy claro.