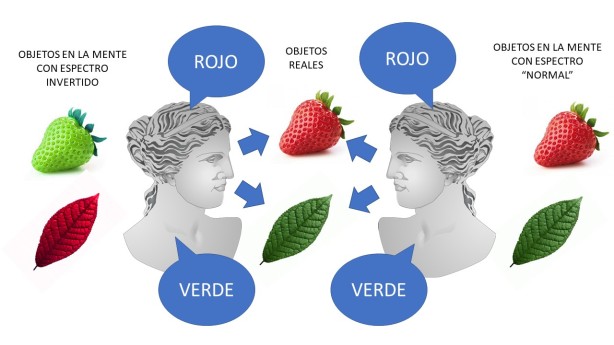

Uno de los argumentos más famosos contra el funcionalismo como teoría de la mente es el argumento del espectro invertido. Supongamos que tenemos a un individuo cuyo espectro de color con respecto al rojo y al verde están invertidos. Desde su nacimiento, él ve rojas las hojas de los árboles o el césped del parque, mientras que ve verde la sangre o las cerezas. Pero, curiosamente, cuando aprendió los colores no tuvo ningún problema. Cuando le enseñaron un muñeco de Elmo y le dijeron que era rojo, aunque él lo veía verde, aprendió a llamarlo «rojo». Así, todos los objetos que veía verdes los llamó «rojos» y viceversa, no teniendo ningún problema para desenvolverse en el mundo. De hecho, este sujeto podría llegar a pasar absolutamente toda su vida viendo todo de forma invertida sin darse cuenta de que percibe de forma muy diferente a los demás.

¿Por qué este argumento pretende refutar el funcionalismo? Porque el funcionalismo define los estados mentales en términos funcionales, es decir, por tener un rol causal entre entradas sensoriales y salidas conductuales. Si decimos que el quale (la cualidad subjetiva) de la sensación del color no tiene ninguna incidencia en el comportamiento (no cumple ninguna función) y, a su vez, mantenemos que el quale es una parte del estado mental, hay partes del estado mental que no se explican por su rol causal. Por lo tanto, el funcionalismo en su versión fuerte (el que sostiene que la definición de un estado mental se agota en su rol causal) sería falso.

Aparentemente, parece un argumento sólido y difícil de objetar. De hecho, para Putnam constituye una de las claras evidencias para desechar el funcionalismo. Tenemos múltiples intentos de rebatirlo en la obra de Dennett (en su «Quining Qualia» de 1988) o de Chalmers (véase todo el capítulo 7 de La Mente Consciente), y ha sido también muy estudiado por autores como Block (1990), Shoemaker (1982), Cole (1990) o Harman (1990). A mi juicio, ninguno ha conseguido refutarlo contundentemente.

No obstante, susodicho argumento no derriba una versión débil del funcionalismo que podríamos definir, a vote pronto, como aquel que defiende que los qualia tienen funciones, aunque la explicación funcional no agote todo lo que es el quale. Los colores tienen una evidente función: la distinción y categorización de los objetos. Precisamente, el argumento del espectro invertido funciona porque al cambiar el quale (el verde por el rojo o viceversa) no incidimos en la función: el sujeto puede seguir categorizando los objetos en clases sin ningún problema. Solo en el caso en que la inversión del espectro no fuera completa (el sujeto cambia solo algunos objetos de color) la función se vería alterada: aunque acertaría en algunos casos, en otros el sujeto diría que son verdes objetos que todo el mundo ve rojos, y viceversa. Entonces ¿Qué es lo que tienen los qualia que sí los hace funcionales? En el caso del color estaría la capacidad de generar contraste. Si, por ejemplo, nuestro espectro visual solo atendiera a una pequeña gama de tonos de verde, todos muy parecidos entre sí, nos sería muy difícil diferenciar objetos. Por el contrario, si pensamos en el rojo y en el verde, son dos colores que se diferencian paradigmáticamente bien. Así, vemos clara la función de, al menos, una cualidad fenoménica del quale.

No obstante, volvemos a subrayar, que algunas propiedades de los qualia sean funcionales no justifica la versión fuerte del funcionalismo: que todo en el qualia es función. Podríamos pensar en un individuo que viera todo en un espectro de tonalidades de gris, desde el blanco nuclear hasta el negro azabache, de modo que conservara la capacidad de generar contraste para ser funcionalmente operativo, pero que no viera ningún otro color (como ya ejemplificamos en este estupendo ejemplo de Olivers Sacks). De nuevo entonces surgiría la cuestión: ¿para qué la experiencia subjetiva de rojo, verde o azul?

Lo que sí se refuta aquí es el epifenomenalismo (en su versión fuerte): la tesis de que la consciencia es solo un residuo, un epifenómeno, de auténticas funciones, pero que carece por completo de función (que, extrañamente, según esta youtuber es la última palabra) . Nada más lejos de la realidad. He puesto el ejemplo del color porque es, filosóficamente hablando, más peliagudo; pero si ponemos otros ejemplos, la función del quale se ve muy clara. Si hablamos del dolor, su función es más que evidente. Sydney Shoemaker nos ofrece tres funciones de los qualia:

- Causar determinada conducta: «Sabe amargo, es posible que esté en mal estado. Lo escupo».

- Causar la creencia de que algo va mal en el organismo: «Me duele la muela, tendré una infección que he de curar».

- Causar la creencia cualitativa de que se está en un estado y no en otro: esta es la que hemos defendido hoy aquí. Me es muy útil diferenciar objetos por sus colores, al igual que me es útil diferenciar las cosas que me proporcionan placer de aquellas que me proporcionan dolor.

Las propiedades del quale sin función quizá deberían entenderse a la forma de las cualidades de los seres vivos sin función adaptativa, siguiendo el celebérrimo artículo de Gould y Lewontin (1979) sobre las pechinas de la catedral de San Marcos (del que ya hablamos aquí). Los qualia tienen propiedades funcionales pero también contienen elementos epifenoménicos (epifenomalismo versión débil), quizá necesarios a algún nivel para realizar tal función (igual que las pechinas de la cúpula de una catedral) o, sencillamente, como un subproducto inevitable (igual que el ruido es un epifenómeno inevitable del funcionamiento normal de un motor de explosión).

Dado todo lo dicho, la postura filosófica más saludable parece la sugerida por Chalmers cuando habla de funcionalismo no reduccionista. Y un programa de investigación, igualmente saludable, sería el de indagar más en las propiedades funcionales de las características fenoménicas de los qualia. Quizá se podría ir, progresivamente, arrinconando epifenómenos y mostrar que, verdaderamente, ver en colores verde y rojo sí que tiene algún tipo de función que, a día de hoy, no atinamos a encontrar.